Тема явно не новая и многие описывают работу с Google Webmaster Tools на своих сайтах. Не могу сказать что их описания будут чем-то сильно отличатся от моих, но все же это важная тема, по этому я посчитал нужным предоставить данную информацию на своем блоге.

Тема относиться к большой главе в SEO — борьба с дублированием контента. Важность данного вопроса тяжело переоценить, ведь неправильная индексация, может очень существенно навредить даже самому популярному сайту.

Search Console не лучший, но действующий способ борьбы с дублирование контента.

Метод борьбы с дублями, создаваемыми WordPress, посредством Search Console является самым простым, не требующим особых знаний в программировании или сайтостроении.

Данная инструкция является больше вспомогательным инструментом защиты от дублирования чем “панацеей от всех болезней”.

Все страницы, которые копируют контент внутри сайта, можно защитить от навязчивых поисковых роботов другими способами, посредством файла robots.txt и его правильного составления, внедрения необходимых мета тегов с одноименным название “robots”, а так же сравнительно нового тега “canonical”.

Все это будет даже правильнее чем предложенный ниже вариант, но если вы пока не в состоянии глубоко окунуться в настройки своего сайта тогда стоит для начала воспользоваться инструментом от Google Webmaster — Параметры URL, о работе с которым и пойдет дальше речь.

Запрет индексирования URL с указанным параметром.

Для того чтобы закрыть от индексации “вредных” страниц нужно для начала зарегистрировать аккаунт в Google, это значит создать почту Gmail. Затем авторизироватся с любого компьютера, желательно со своего, и добавить ваш сайт в Google Webmaster Tools.

После того как вы подтвердите право собственности на сайт вам станет доступна информация и настройки Searh Console.

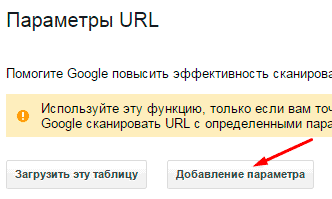

В панели вебмастера Google, во вкладке “Сканирование”, переходим в пункт меню “Параметры URL”. Ну что же мы попали туда куда нужно, именно тут и происходит настройка параметров индексирования. Перед тем как приступить хочу вас предостеречь, если вы не верно укажите нужный вам параметр или же он будет в каком-нибудь другом URL оказавшись там случайным образом, это может выкинуть некоторые страницы из индекса, пример такой ошибки приведу ниже.

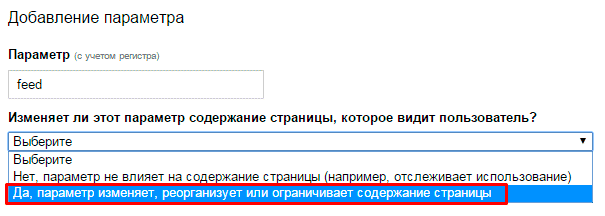

Итак, приступим к нашим настройкам, для начала нужно добавить необходимый параметр блокировки. Для примера выберем “злокачественные” страницы с окончанием “feed” генерируемые WordPress. Эти страницы создает встроенный RSS в нашу платформу.

Нажимаем на кнопку “Добавление параметров”, нам откроется диалоговое окно:

В первой форме вводим точное название параметра, в нашем случае это “feed” и выбираем пункт “Да, параметр изменяет, реорганизует или ограничивает содержание страницы”.

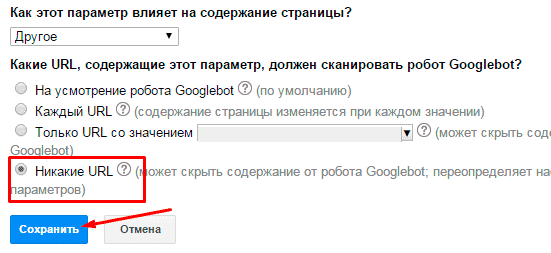

После этого нужно проставить еще настроек:

Выбираем “Другое” и “Никакие URL”, далее нажимаем “Сохранить”. На этом наша “сложная” настройка завершена для параметра “feed”.

Таким же способом вы можете запретить индексировать страницы пагинации, рубрики, метки и вообще любую страницу сайта, просто подставив необходимый кусок URL.

Какие параметры URL стоит закрывать от индексации Google Webmasters Tools в WordPress?

Приведенный ниже список является только примером, а не обязательным правилом, все зависит от многих других настроек.

- Параметр “tag” — чаще всего страницы меток не оптимизированы и не имеют уникального текстового контента, по этому они могут создавать частичные дубли. Закрывать от индексации или нет решать только вам.

- Параметр “category” — некоторые вебмастера закрывают и категории от индексации, что совсем не приемлемо. Стоит оптимизировать рубрики, это даст вам и дополнительный трафик и передаст больше веса на страницы сайта.

- Параметр “replytocom” — долго рассказывать не буду, скажу что такие url однозначно создают дубли, и их нужно закрывать. Связанные они с формирование древовидных комментариев к публикациям.

- Параметр “page” — не лучший способ борьбы с дублями пагинации, лучше использовать в этих целях мета теги, но пока вы этого не сделали, стоит внести и этот параметр.

Так же можно вносить и многие другие варианты, но большинство из них успешно закрываются в robots.txt, ссылка на статью о котором есть вначале поста.

Что бы ответить на этот вопрос приведу небольшой пример.

Допустим мы указали запрет по параметру “tag”, закрыли страницы с метками от индексации, но мы совсем забыли что у нас есть статья о этих самых метках или о чем нибудь другом, URL страницы которой mysite.ru/info-tag.

Такие ситуации встречаются, что бы такого не возникало стоит либо не использовать слово в URL, либо все таки сесть и разобраться с другими вариантами настройки индексации страниц, без использования Google.

На этом руководство закончено, урок был небольшим, но значительным, по этому стоит с большой серьезностью отнестись к вопросу дублирования контента.

Попробую, должно получится. спасибо

Обязательно получиться. Главное внимательно используйте настройку. Совместно с файлом роботс работает отлично! Можно проверить на примере моего блога, более 90% целевых страниц проиндексировать. Меньше 10% дублей и их число постоянно уменьшаеться.

Можно ли как то удалить весь сайт с индекса, при помощи Параметры URL Google?