Файл robots.txt это первоначальный, и один из главнейших инструментов для корректной индексации ваших сайтов и их контента. Отсутствие данного файла приведет к печальным последствиям которые тяжело будет исправить. От того как вы настроите robots.txt зависит что попадет в выдачу по запросам в поисковых системах. Сейчас рассмотрим правильный файл robots.txt для WordPress сайта.

Для чего использовать robots.txt?

Перед тем как приступать к созданию и наполнению давайте разберем саму суть данного файла.

Ваш сайт это набор файлов и папок, некоторые из которых нужно защитить от чтения от сторонних глаз, которыми являются так же и поисковые роботы, пришедшие прочитать и запомнить наш контент, для дальнейшей выдачи в поиске.

Чем занимается поисковой робот на сайте?

Итак, к примеру ваш сайт посетил поисковой робот, что он делает в первую очередь? Во-первых пытается найти уникальную информацию, которую сможет занести в свою базу данных. Если роботс отсутствует, а именно к нему в первую очередь обращается робот, тогда он начинает “читать” файлы находящиеся в корне сайта, что конечно же нам не очень понравиться, ведь он не только не найдет там нужную ему информацию, а и прочитает наши данные настроек, которые созданы для нашей личной цели. Именно для этого и существует robots.txt. Он дает указания роботу куда ходить нужно, а куда заглядывать не стоит.

Создание и размещение файла на сайте WordPress.

Для того что бы создать путеводитель для роботов, вам потребуется обычный блокнот windows, в котором вы будете прописывать нужные команды для поисковых роботов. После этого нужно сохранить файл в формате “txt”, под названием “robots”. На этом создание завершено, далее в статье мы рассмотрим какие же команды должны находиться в robots.txt для WordPress.

Где размещать?

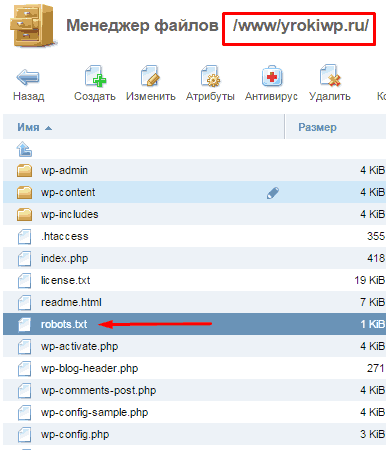

Robots.txt размещается на вашем хостинге, непосредственно в корневой папке сайта, куда мы перенесли наш сайт. Теперь поисковой робот перед тем как лазить по нашему сайту, сначала спросит разрешение куда ему можно, а куда запрещено заходить.

Важно: при размещении документа в подкаталогах, роботы не смогут найти этот файл.

Зайдя к вам на сайт робот заходит смотрит предназначеную для него “инструкцию” и начинает его изучать. Изучив до конца он пойдет по выбранному вами пути индексации, и будет игнорировать те директории, папки и URL к которым вы запретили обращаться.

Что включает в себя роботс?

Robots.txt несет в себе информативные данные для поисковых роботов и включает в себя такие основные “команды”:

User-agent

Указывает на имя потенциального робота посетителя. Синтаксис “User-agent: *” будет означать что данным командам должны следовать все роботы. Варианты для отдельных роботов рассматривать не будем, их очень много. По этому для примера будет только два варианта (для всех роботов и отдельно для Яндекс).

Disallow

Команда для роботов, рассказывающая о том куда ходить не стоит, запрещает чтение указанных адресов и файлов.

Allow

Команда которая рекомендует “направление” на индексирования данного адреса или файла.

Host

Данная команда указывает роботу, какой из вариантов сайта будет нашим главным зеркалом сайта.

Sitemap

Место нахождения xml карты сайта по которой должен пробежаться посетивший нас робот, в той части за которой он пришел (контент сайта).

Правильный robots.txt для сайта на CMS WordPress.

Для того что бы правильно настроить файл robots.txt специально под “движок” WordPress нужно для начала понимать что ищут роботы и что им будет интересно.

А наши паучки ищут контент нашего ресурса, и им совершенно не нужно знать о всех остальных конфигурационных данных наших сайтов. Во первых они им приходятся не по вкусу, и от переедания таковых они могут покинуть наш сайт так и не найдя то что нам бы хотелось да еще и вынесут наши запрещенные для общего глаза данные на общее обозрение.

Говоря о требуемых размещения директорий в robots.txt для WordPress, нам нужно разобраться с главной (корневой) папкой нашего сайта, в которой мы обнаружим огромное количество стандартных файлов и папок. Роботам незачем их читать, они не найдут там то что ищут, по этому нужно запрещать индексировать по возможности весь “лишний мусор”.

Подумайте сами чем может сулить нам например индексация нашего wp-config.php. Робот просто возьмет и “расскажет” всем о наших вводных данных к нашим базам данных, а это крайне плохо для нас.

Сейчас я покажу готовый вариант. Затем разберем каждую строчку в расширенном описании. Итак, правильный robots.txt для WordPress должен выглядеть так:

Disallow: /wp-

Disallow: */trackback

Disallow: /*?*

Disallow: /?s=*

Disallow: */author

Disallow: /2016

Disallow: /xmlrpc.php

Allow: /wp-content/uploads/

Allow: *.js

Allow: *.css

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

Теперь посмотрим как мы смогли добиться такого короткого содержания файла robots.txt для WordPress, рассмотрим расширенную версию файла и постепенно уберем повторы:

Disallow: /wp-includes # папки includes

Disallow: /wp-content/languages # папки content/languages

Disallow: /wp-content/plugins # папки content/plugins

Disallow: /wp-content/cache # папки content/cache

Disallow: /wp-content/themes # папки content/themes

Disallow: /trackback # блокируем индекс всех возможных трекбеков

Disallow: */trackback

Disallow: */*/trackback

Disallow: */feed # блокируем индексацию фидов, новостных лент всех вариантов

Disallow: /feed/

Disallow: /?feed=

Disallow: */*/feed

Disallow: */*/feed/*/

Disallow: /*?* # запрет индекса всех ссылок (защита от дублей)

Disallow: /tag # каталоги находящихся в разных директориях ( метки, категории )

Disallow: /tag/*

Disallow: /?s=*

Disallow: /page/* # запрещаем лишние страницы в WP, создающие дубли

Disallow: /author # блокировка индексации автора

Disallow: /2015 # дублирование ссылок с архива # далее блокировка всех административных файлов

Disallow: /xmlrpc.php

Disallow: /wp-activate.php

Disallow: /wp-blog-header.php

Disallow: /wp-comments-post.php

Disallow: /wp-config.php

Disallow: /wp-cron.php

Disallow: /wp-links-opml.php

Disallow: /wp-load.php

Disallow: /wp-login.php

Disallow: /wp-mail.php

Disallow: /wp-register.php

Disallow: /wp-settings.php

Disallow: /wp-signup.php

Disallow: /wp-trackback.php

Disallow: /wp-config-sample.php

Allow: /wp-content/uploads/ # Разрешаем индексировать наши загруженные картинки

Host: site.ru # Указываем основное зеркало

Sitemap: http://site.ru/sitemap.xml # Направляем робота на наши страницы контента

Указанный выше пример заблокирует от индексации все ненужные для поисковой оптимизации файлы и ссылки и укажет на тот материал который должен быть проиндексирован.

Ну уж очень длинный у нас вышел пример, сейчас мы его будем упрощать. Для начала возьмемся за файлы и папки с префиксом “wp-“ их все можно объединить воедино.

Disallow: /wp-

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */feed

Disallow: /feed/

Disallow: /?feed=

Disallow: */*/feed

Disallow: */*/feed/*/

Disallow: /*?*

Disallow: /tag

Disallow: /tag/*

Disallow: /?s=*

Disallow: /page/*

Disallow: /author

Disallow: /2015

Disallow: /xmlrpc.php

Allow: /wp-content/uploads/

Allow: *.js

Allow: *.css

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

Значительно уменьшили, но это не предел, пойдем немножко дальше и постараемся еще сократить, да еще и проделать необходимые внутренние настройки.

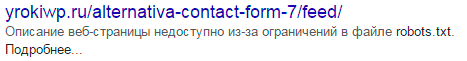

Все дело в том что при таком варианте файла, Google все равно внесет запрещенные вами страницы в индекс, но выглядеть они будут иначе:

Это не столь опасно как открытые дубли, но все же лучше от этого избавляться. Для того что бы исправить данную ситуацию можно воспользоваться сразу несколькими методами. Я расскажу о самом быстром и простом — запрет индексирования страниц с помощью Google Webmasters Tools “Параметры URL”. Кстати в рекомендациях для Яндекса лучше оставить параметр “feed” в указанном варианте.

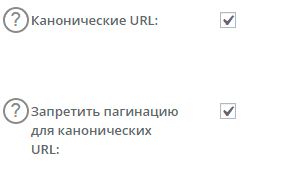

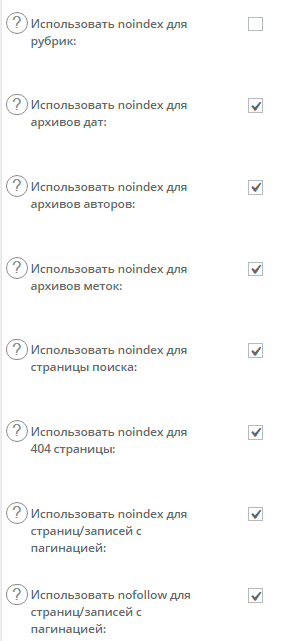

Избавились от feed с помощью Google, теперь для альтернативы запретим индексирование пагинации с помощью плагина, который скорее всего используется вами, если же это не так, тогда альтернативный так же подойдет. Речь идет о All in One SEO и его настройках тегов “robots” и “canonical”.

Для того что бы запретить индексировать поисковикам не нужные нам страницы, такие как страницы пагинации всех видов (главной, рубрик и меток) нужно всего навсего поставить галочки в нужных местах.

Сперва включим канонические ссылки на главные страницы, для избежания их дублирования.

Что мы сделали? В общем все что было нужно, мы указали на страницах которые дублируют наш контент ссылку на основную страницу, что укажет роботу что именно нужно сканировать и считать за основной контент. Теперь добавим еще мета тег robots.

После проведенных настроек, снова обращаемся к нашему варианту файла и смотрим что получилось:

Disallow: /wp-

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: /*?*

Disallow: /?s=*

Disallow: /author

Disallow: /2015

Disallow: /xmlrpc.php

Allow: /wp-content/uploads/

Allow: *.js

Allow: *.css

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

По поводу меток и рубрик вопрос спорный, вы можете оптимизировать рубрики, и добиться результата с которым ваши страницы категорий будут не вредны, а наоборот принесут дополнительный трафик. Метки можно подогнать под поисковики аналогично рубрикам.

Если тема, которую вы установили использует картинки, тогда лучше открыть их для индекса:

Allow: /wp-content/themes/название вашей темы/images

Если вы проигнорируете это, у вас могут возникнуть проблемы с поисковиками, они не любят когда от них скрывают важную информацию.

Пример можно расширять, например добавлением запрета для индексации определенных ссылок на страницы, обычно это страницы повторы которые вредят нашей оптимизации.

В документе обычно не указывают конкретно для всех поисковых роботов по отдельности, а делаю два набора команд один для всех второй для Яндекса.

Sitemap: http://site.ru/sitemap.xml

Host — нужно обязательно указывать, пренебрежение приведет к дублирования индексации ваших страниц между www.site.ru и site.ru, что рассеет ваш трафик и пагубно скажется на вашем сайте.

Как правильно создать карту сайта можно почитать в отдельных уроках по WordPress.

На этом урок по созданию файла robots.txt заканчивается, и помните что от этого по большей степени зависит судьба индексации ваших страниц.

Супер, одно из лучших руководств! Спасибо!

Пожалуйста, рад помочь.

Отличное руководство, все очень хорошо разжевано, благодарю!

Здравствуйте! Хорошая полная статья! Но у меня возник вопрос по поводу ява скриптов. Вы рекомендуете allow. Тогда как почти везде ява скрипты запрещаются к чтению для роботов.Это Ваше личное предпочтение или же лучше оставить их закрытими? И еще ворос в догонку,файл квик инстолла .qidb так же лучше закрыть? Спасибо!

Google рекомендует открывать все скрипты и файлы стилей для индексации, это не мое предпочтение, а рекомендация поисковой системы. Сегодня гугл боты должны видеть сайт так же как и пользователи, по этому закрывая индексацию скриптов получите предупреждение при проверке сайта в Вебмастере Гугл (Посмотреть как гуглбот). Другое дело закрывать от индексации ссылки скриптов в ноиндекс и нофолов, но это совсем другая история)

Касательно файлов инсталов. Файл роботс предназначен для того, что бы показать ботам где контент, а где серверные технические данные, по этому все что не несет информационной нагрузки должно быть закрыто.

Спасибо за разьяснения! Все понятно. Буквально сейчас столкнулась с еще одной задачкой…

При вводе логина в контрол панель(я на хостагаторе) моего хостинга, почему-то просит двва раза ввести пароль??? Причем пишет что первый раз вы успешно вышли.Хотя я вышла из панели.Странно как-то…Затем зайдя в админку увидела какой-то левый айпи под моим логином.Пробила по блак листу ОКАЗАЛОСЬ,что этот айпи находится в черном списке из-за спама!! И это не мой айпи.Как Вы думаете, кто-то уже залез на мой хостинг? Может Вы сталкивались с подобным? Есть каке-то советы по поводу? Буду очень признательна за совет

Думаю уже залезли на сайт, на хостинг менее вероятно, хотя возможно. Если был вход под вашим логином тогда нужно оперативно сменить пароль, а еще лучше и логин (удалить старый создать новый). По поводу двойного залогинивания, то такой подход существует но если он возник сам по себе, что конечно же не реально тогда над сайтом уже “поработали”. Тут особых рекомендаций не дам, нужно проверять все и не откладывая.

Здравствуйте!

Увидел у Вас такую команду:

*********************************

Disallow: /2015

*********************************

А что это за папка такая? У меня вроде нет такой…

Спасибо!

С ув., Олег

P/s Я – “я чайник”…

Если у вас блог и есть записи по дням, тогда у вас имеется архив. Архивы нужно закрыть от индексации. Или же поработать над уникальностью страницы. Введите в адресной строке своего или моего сайта такое yrokiwp.ru/2015 и вам покажет статьи только за 2015 год. Такой вот принцип.

Разве Disallow: /*?* не включает в себя Disallow: /?s=* ?

ответил вам на почту) включает, но при некоторых ситуациях нужно использовать только второе, так как первое может навредить индексации некоторых страниц, это крайне редко, но знать это нужно

Зачем нужны три правила?

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Разве не достаточно одного?

Disallow: */trackback

Отличная статья дает понимание назначения файла pobots.txt

Здравствуйте. Подскажите пожалуйста ответ на следующий вопрос. У меня сайт новый, статьи ещё не выпускались. префикс базы данных я поменял с помощью плагина All In One WP Security & Firewall . Поскольку сайт (“нулевой”) то сама смена прошла безболезненно.

Вопрос в следующем. Какой префикс прописывать при составление файла Robots.txt когда указывается директива Disallow (wp_ или уже новый изменённый). Если новый, тогда возникает вопрос (заранее извините за возможную некорректность формулировки) — в чём тогда его секретность, если посмотреть его сможет любой желающий, дописав в браузерной строке после слэша robots.txt

Спасибо.

С Уважением.

База данных и файл роботс между собой не связаны. Файл роботс можно посмотреть на любом сайте, он не секретный, он служит путеводителем и правилом для правильной индексации СТРАНИЦ сайта. В роботс так же и остаеться все по прежнему wp-admin … и т.д.

Благодарю за консультацию.

Здравствуйте.Вопрос-нужна ли индексация картинок для дорвея?Если нет,то как её отключить?

С уважением.

Вот в этой статье dampi.ru/pravilnyiy-robots-txt-dlya-sayta-na-wordpress автор утверждает о том, что если открыть uploads для всех ботов, то в индексе появляются загруженные PDF и прочие текстовые файлы. А в яндекс вебмастере, в отчете “Исключенные страницы” появляются сообщения об ошибке при индексировании картинок, мол содержимое не поддерживается. Вот и не знаю кому верить…

Спасибо за подробную статью. Прекрасное и понятное изложение